0

| 本文作者: AI研習社 | 2020-03-06 15:38 |

使用多個攝像機的實時多人運動捕捉的4D關聯圖

放大學習:將深度立體匹配網絡泛化到新穎場景

面向深度人臉識別的通用表征學習

用于零樣本超分辨率的元轉移學習

基于有偏訓練的無偏場景圖生成

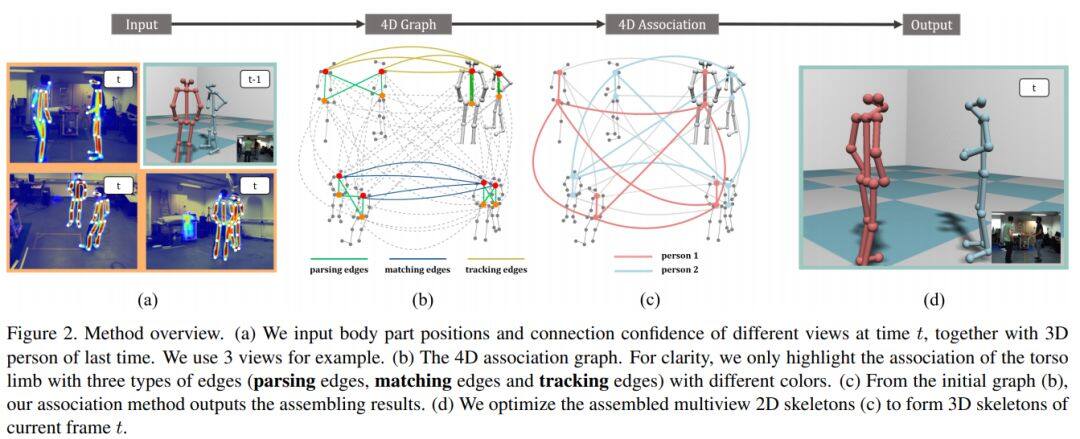

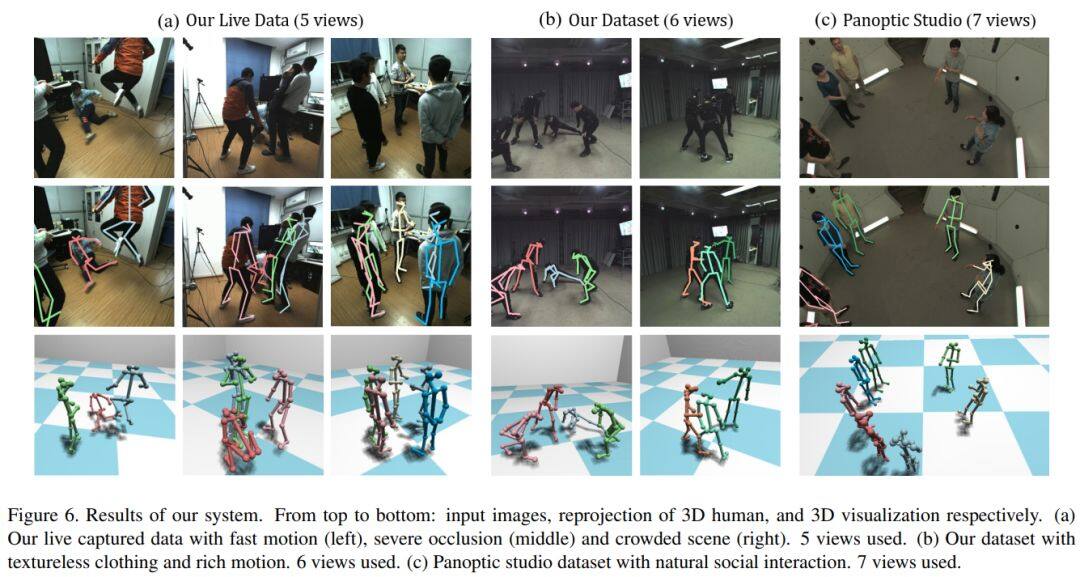

論文名稱:4D Association Graph for Realtime Multi-person Motion Capture Using Multiple Video Cameras

作者: Zhang Yuxiang /An Liang /Yu Tao /Li Xiu /Li Kun /Liu Yebin

發表時間:2020/2/28

論文鏈接:https://paper.yanxishe.com/review/12957?from=leiphonecolumn_paperreview0306

推薦原因

這篇論文被CVPR 2020接收,提出了一種新的使用多視點視頻輸入的實時多人運動捕捉算法,首次將視圖解析、跨視圖匹配和時間跟蹤整合到一個優化框架中,即得到一個4D關聯圖,該圖可以同時平等地處理每個維度(圖像空間、視點和時間)。為有效求解4D關聯圖,這篇論文進一步提出基于啟發式搜索的4D肢束解析思想,然后通過提出束Kruskal算法對肢束進行組合。這個新算法可以在5人場景中使用5個攝像機,以30fps的速度運行實時在線運動捕捉系統。新算法不僅對噪聲檢測具有魯棒性,還獲得了高質量的在線姿態重建結果。在不使用高級外觀信息的情況下,新算法優于當前最優方法。

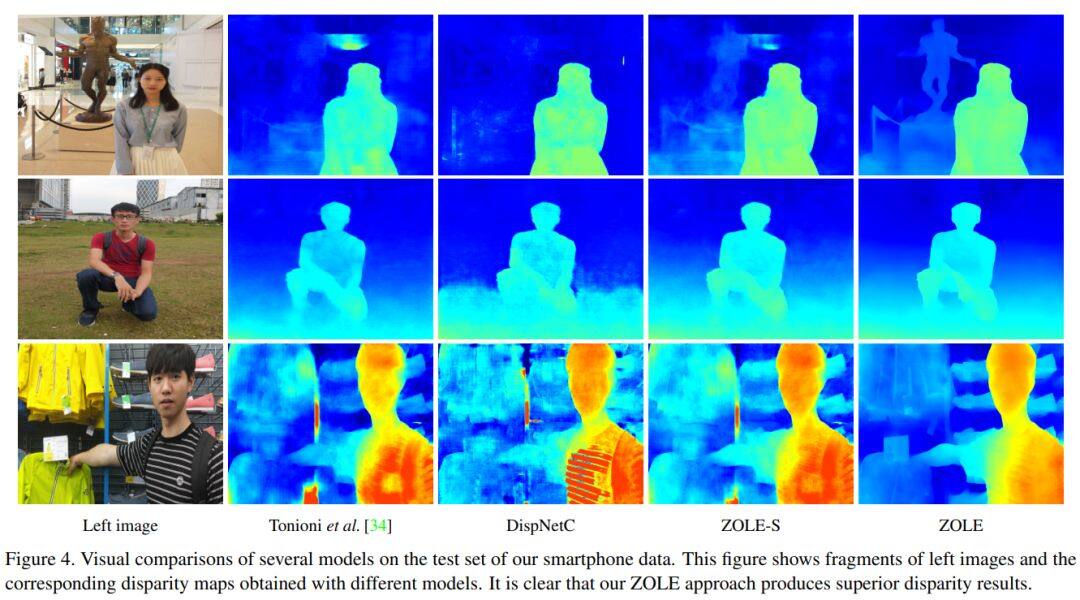

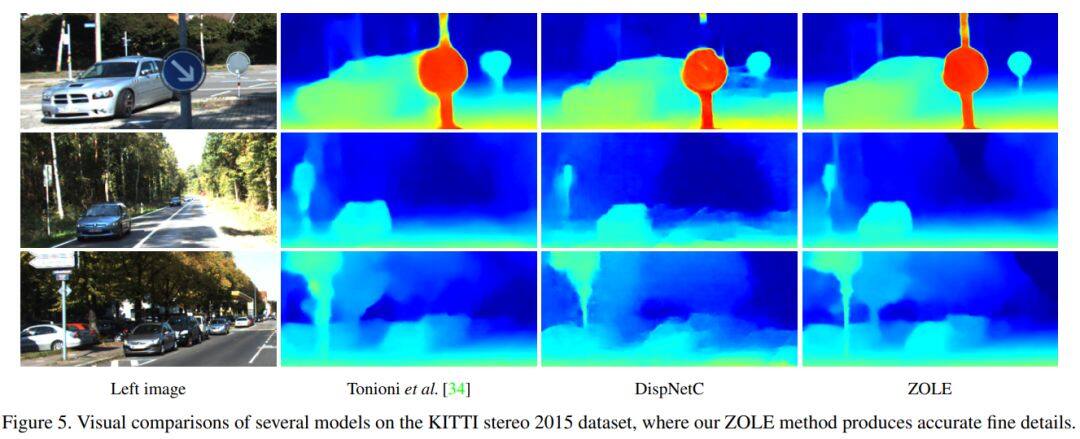

論文名稱:Zoom and Learn: Generalizing Deep Stereo Matching to Novel Domains

作者: Pang Jiahao /Sun Wenxiu /Yang Chengxi /Ren Jimmy /Xiao Ruichao /Zeng Jin /Lin Liang

發表時間:2018/3/18

論文鏈接:https://paper.yanxishe.com/review/12831?from=leiphonecolumn_paperreview0306

推薦原因

本文核心是解決深度立體匹配模型在合成數據上預訓練后在真實數據上泛化能力很弱的問題。作者觀察到,將真實數據放大后輸入由合成數據預訓練的模型,其結果比原始大小輸入會更加精細化。因此,這種放大真實數據得到的視差圖可以作為一種“真實”視差進行監督。另外,作者借鑒圖拉普帕斯正則化技術,對得到的視差圖進行約束,可以有效去除合成數據上預訓練模型產生的噪聲和失真現象,并且視差圖更加光滑,邊緣更加細致。這篇論文也表明了域自適應的兩個關鍵因素:(1)真實數據應當具有較為可靠的“偽標簽”監督;(2)視差圖需要平滑且保留邊緣的約束條件。該論文收錄在CVPR 2018。

論文名稱:Towards Universal Representation Learning for Deep Face Recognition

作者: Shi Yichun /Yu Xiang /Sohn Kihyuk /Chandraker Manmohan /Jain Anil K.

發表時間:2020/2/26

論文鏈接:https://paper.yanxishe.com/review/12830?from=leiphonecolumn_paperreview0306

推薦原因

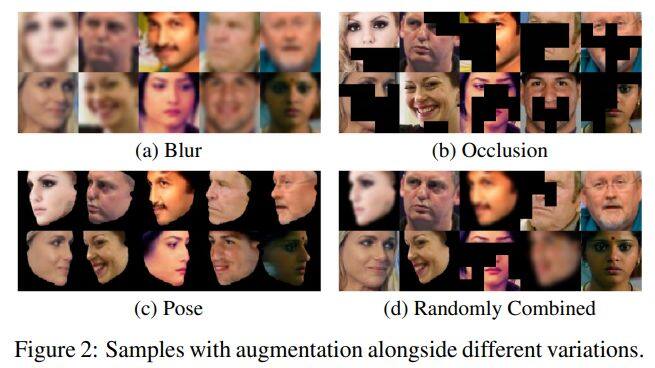

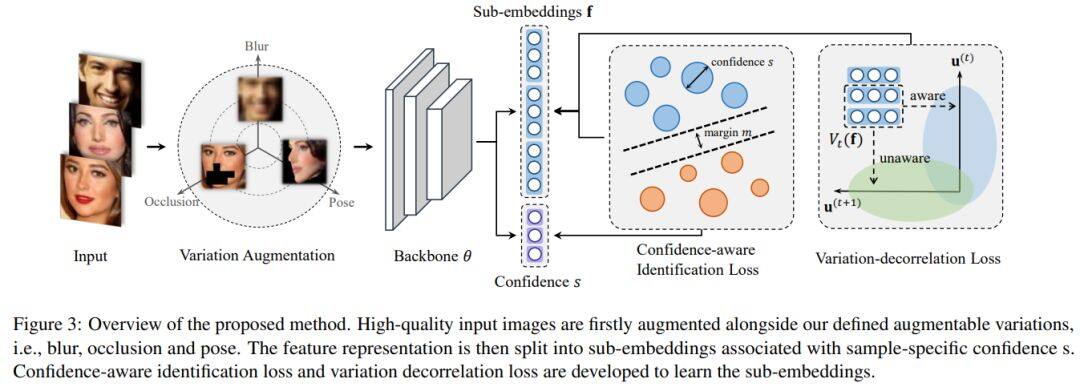

這篇論文被CVPR 2020接收,提出了一種面向深度人臉識別的通用表征學習框架,可以處理給定訓練數據中未發現的較大變化,而無需利用目標域知識。新框架首先將訓練數據與一些有意義的語義變化(例如低分辨率、遮擋和頭部姿勢)一起合成。訓練過程中將特征嵌入拆分為多個子嵌入,并為每個子嵌入關聯不同的置信度值,以簡化訓練過程。通過對變化的分類損失和對抗性損失進行正則化,可進一步對子嵌入進行解相關。實驗表明,新的框架在LFW和MegaFace等常規人臉識別數據集上均取得最佳性能,而在TinyFace和IJB-S等極端基準集上則明顯優于對比算法。

論文名稱:Meta-Transfer Learning for Zero-Shot Super-Resolution

作者: Soh Jae Woong /Cho Sunwoo /Cho Nam Ik

發表時間:2020/2/27

論文鏈接:https://paper.yanxishe.com/review/12829?from=leiphonecolumn_paperreview0306

推薦原因

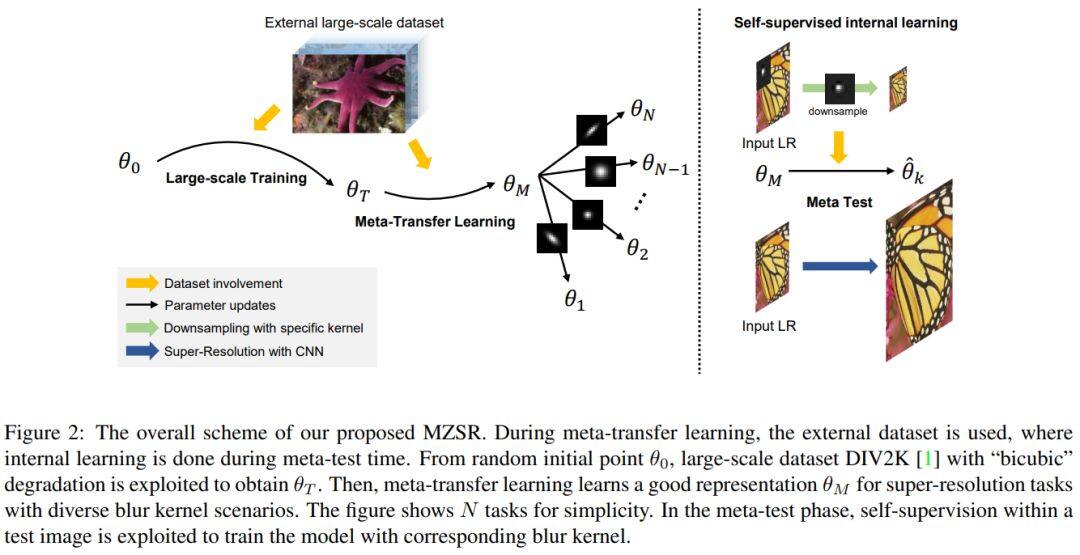

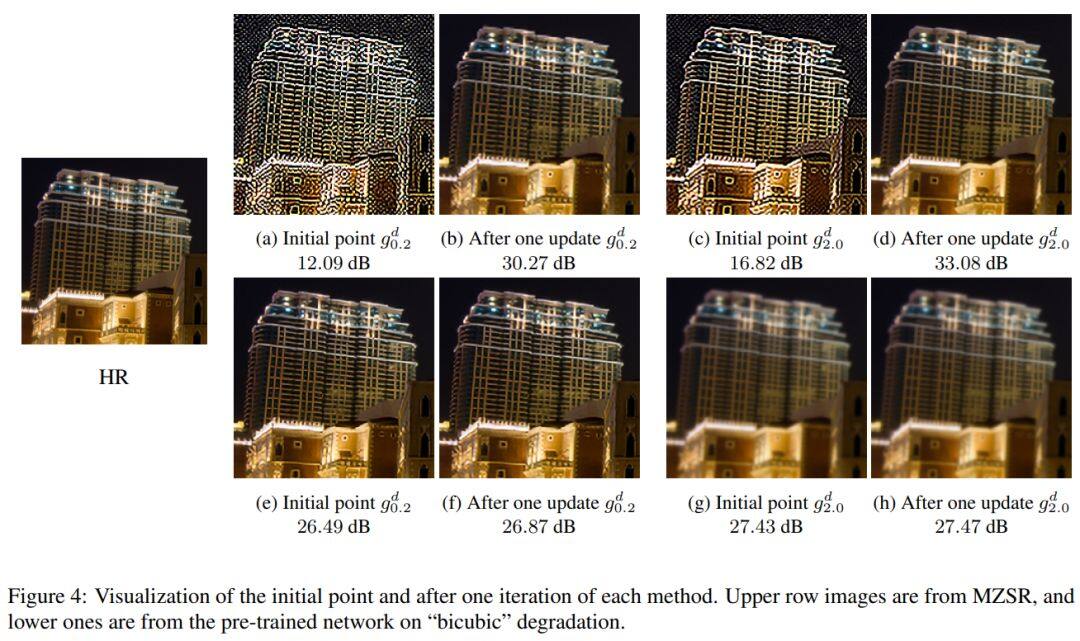

這篇論文被CVPR 2020接收,考慮的是零樣本超分辨率的問題。

以往的零樣本超分辨率方法需要數千次梯度更新,推理時間長。這篇論文提出用于零樣本超分辨率的元轉移學習。基于找到適合內部學習的通用初始參數,所提方法可以利用外部和內部信息,一次梯度更新就可以產生相當可觀的結果,因此能快速適應給定的圖像條件,并且應用于大范圍圖像。

論文名稱:Unbiased Scene Graph Generation from Biased Training

作者: Tang Kaihua /Niu Yulei /Huang Jianqiang /Shi Jiaxin /Zhang Hanwang

發表時間:2020/2/27

論文鏈接:https://paper.yanxishe.com/review/12828?from=leiphonecolumn_paperreview0306

推薦原因

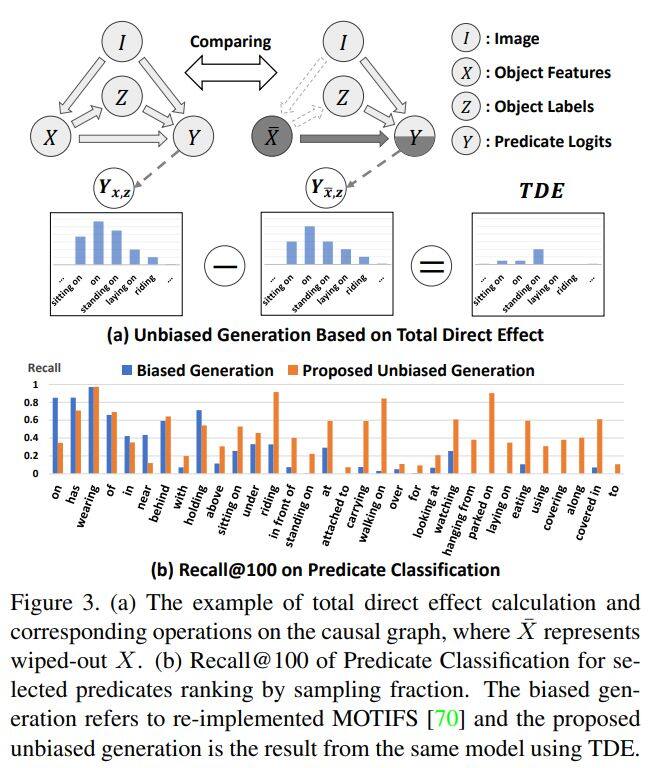

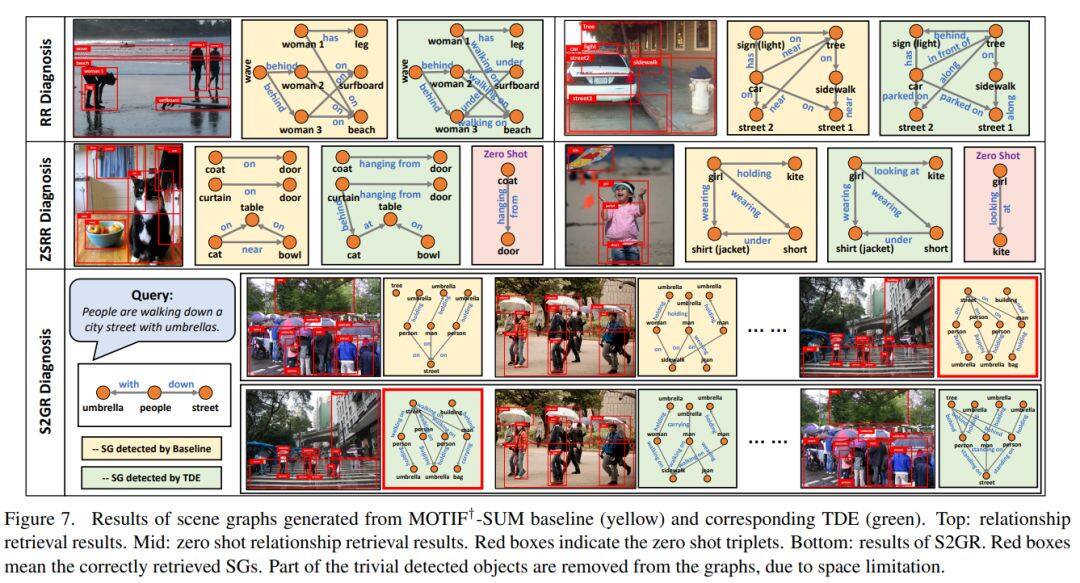

這篇論文被CVPR 2020接收,要解決的是場景圖生成的問題。

已有的場景圖生成容易受有訓練偏見的問題,例如將海灘上人類的步行、坐、躺等多樣行為類型籠統分為海灘上的人類。這篇論文提出了一種新的基于因果推理的場景圖生成的框架。首先建立因果圖,然后使用該圖進行傳統的有偏訓練,接著從訓練圖上得出反事實因果關系,以從不良偏置中推斷出影響并將其消除。場景生成基準集Visual Genome上的實驗表明這篇論文所提的方法與以前的最佳方法相比有顯著改進。

為了更好地服務廣大 AI 青年,AI 研習社正式推出全新「論文」版塊,希望以論文作為聚合 AI 學生青年的「興趣點」,通過論文整理推薦、點評解讀、代碼復現。致力成為國內外前沿研究成果學習討論和發表的聚集地,也讓優秀科研得到更為廣泛的傳播和認可。

我們希望熱愛學術的你,可以加入我們的論文作者團隊。

加入論文作者團隊你可以獲得

1.署著你名字的文章,將你打造成最耀眼的學術明星

2.豐厚的稿酬

3.AI 名企內推、大會門票福利、獨家周邊紀念品等等等。

加入論文作者團隊你需要:

1.將你喜歡的論文推薦給廣大的研習社社友

2.撰寫論文解讀

如果你已經準備好加入 AI 研習社的論文兼職作者團隊,可以添加運營小姐姐的微信(ID:julylihuaijiang),備注“論文兼職作者”

雷鋒網雷鋒網雷鋒網

相關文章:

今日 Paper | Social-STGCNN;說話人臉視頻生成;食材圖像合成;光場角度超分辨率等

雷峰網原創文章,未經授權禁止轉載。詳情見轉載須知。