0

| 本文作者: AI研習社 | 2020-03-24 16:42 |

12-in-1: 多任務視覺和語言表示學習

CVPR 2020 | 用于零樣本超分辨率的元轉移學習

CVPR 2020 | ABCNet:基于自適應Bezier-Curve網絡的實時場景文本定位

CVPR 2020 | Sketch Less for More:基于細粒度草圖的動態圖像檢索

CVPR 2020 | PointAugment:一種自動增強的點云分類框架

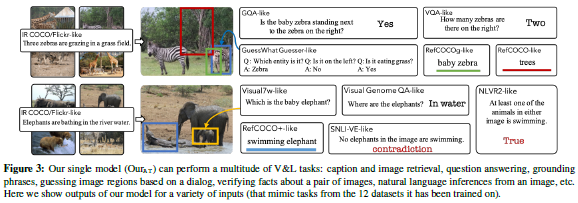

論文名稱:12-in-1: Multi-Task Vision and Language Representation Learning

作者:Jiasen Lu

發表時間:2019/12/11

論文鏈接:https://paper.yanxishe.com/review/13547?from=leiphonecolumn_paperreview0324

推薦原因

本文研究意義:

當下AI模型的實驗數據集都是小而多樣的,這對于后續模型的訓練都會造成很大的影響,在此背景下,本文介紹了一項新穎的數據調度方法——多任務模型,以幫助避免過度訓練或訓練不足。為了驗證該方法是否可行,作者分別在12個視覺和語言數據集上進行了實驗,結果表明,使用這種方法后,我們的單一多任務模型優于12個單一任務模型,這一新方法也為后續的研究帶來了新潮流。

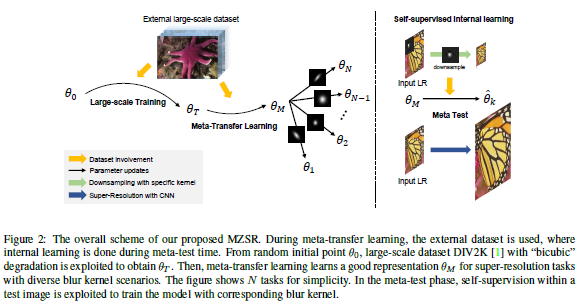

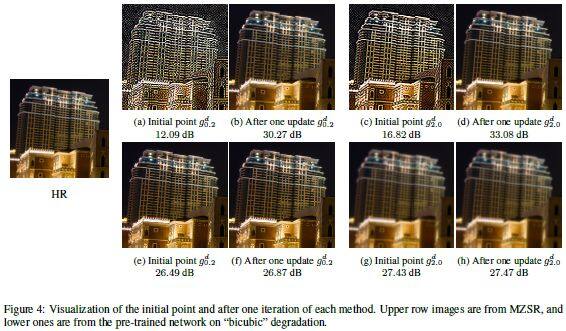

論文名稱:Meta-Transfer Learning for Zero-Shot Super-Resolution

作者:Soh Jae Woong /Cho Sunwoo /Cho Nam Ik

發表時間:2020/2/27

論文鏈接:https://paper.yanxishe.com/review/12829?from=leiphonecolumn_paperreview0324

推薦原因

這篇論文被CVPR 2020接收,考慮的是零樣本超分辨率的問題。

以往的零樣本超分辨率方法需要數千次梯度更新,推理時間長。這篇論文提出用于零樣本超分辨率的元轉移學習。基于找到適合內部學習的通用初始參數,所提方法可以利用外部和內部信息,一次梯度更新就可以產生相當可觀的結果,因此能快速適應給定的圖像條件,并且應用于大范圍圖像。

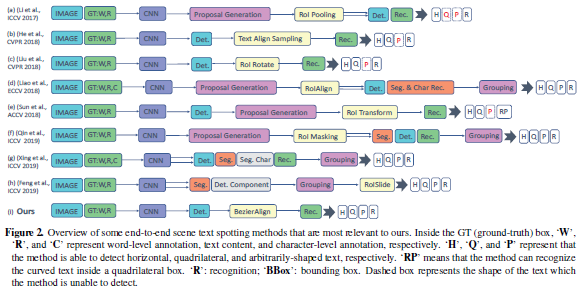

論文名稱:ABCNet: Real-time Scene Text Spotting with Adaptive Bezier-Curve Network

作者:Liu Yuliang /Chen Hao /Shen Chunhua /He Tong /Jin Lianwen /Wang Liangwei

發表時間:2020/2/24

論文鏈接:https://paper.yanxishe.com/review/12441?from=leiphonecolumn_paperreview0324

推薦原因

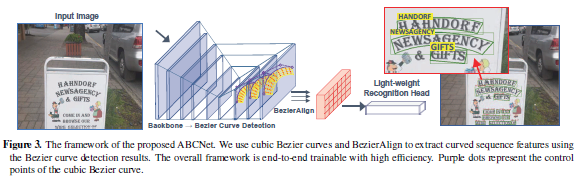

這篇論文被CVPR 2020接收,考慮的是場景文本檢測和識別的問題。

現有方法基于字符或基于分段,要么在字符標注上成本很高,要么需要維護復雜的工作流,都不適用于實時應用程序。這篇論文提出了自適應貝塞爾曲線網絡(Adaptive Bezier-Curve Network ,ABCNet),包括三個方面的創新:1)首次通過參數化的貝塞爾曲線自適應擬合任意形狀文本;2)設計新的BezierAlign層,用于提取具有任意形狀的文本樣本的準確卷積特征,與以前方法相比顯著提高精度;3)與標準圖形框檢測相比,所提貝塞爾曲線檢測引入的計算開銷可忽略不計,從而使該方法在效率和準確性上均具優勢。對任意形狀的基準數據集Total-Text和CTW1500進行的實驗表明,ABCNet達到當前最佳的準確性,同時顯著提高了速度,特別是在Total-Text上,ABCNet的實時版本比當前最佳方法快10倍以上,且在識別精度上極具競爭力。

論文名稱:Sketch Less for More: On-the-Fly Fine-Grained Sketch Based Image Retrieval

作者:Bhunia Ayan Kumar /Yang Yongxin /Hospedales Timothy M. /Xiang Tao /Song Yi-Zhe

發表時間:2020/2/24

論文鏈接:https://paper.yanxishe.com/review/12442?from=leiphonecolumn_paperreview0324

推薦原因

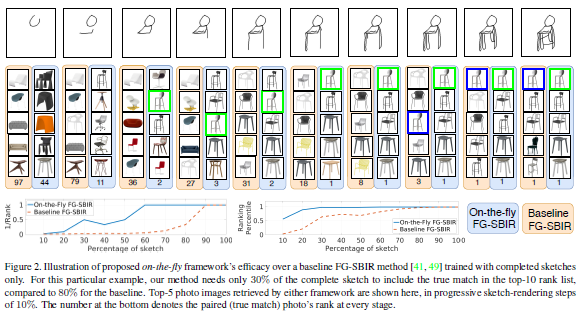

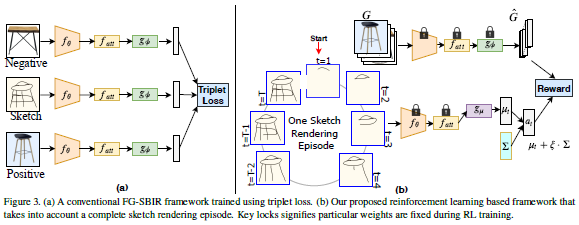

這篇論文被CVPR 2020接收,考慮的是基于草圖的細粒度圖像檢索,即在給定用戶查詢草圖的情況下檢索特定照片樣本的問題。

繪制草圖花費時間,且大多數人都難以繪制完整而忠實的草圖。為此這篇論文重新設計了檢索框架以應對這個挑戰,目標是以最少筆觸數檢索到目標照片。這篇論文還提出一種基于強化學習的跨模態檢索框架,一旦用戶開始繪制,便會立即開始檢索。此外,這篇論文還提出一種新的獎勵方案,該方案規避了與無關的筆畫筆觸相關的問題,從而在檢索過程中為模型提供更一致的等級列表。在兩個公開可用的細粒度草圖檢索數據集上的實驗表明,這篇論文所提方法比當前最佳方法具有更高的早期檢索效率。

論文名稱:PointAugment: an Auto-Augmentation Framework for Point Cloud Classification

作者:Li Ruihui /Li Xianzhi /Heng Pheng-Ann /Fu Chi-Wing

發表時間:2020/2/25

論文鏈接:https://paper.yanxishe.com/review/12686?from=leiphonecolumn_paperreview0324

推薦原因

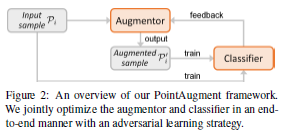

這篇論文被CVPR 2020接收,要解決的是點云分類的問題。

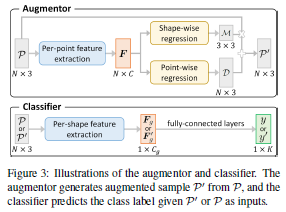

這篇論文提出了一個名為PointAugment的點云分類框架,當訓練分類網絡時,該框架會自動優化和擴充點云樣本以豐富數據多樣性。與現有的2D圖像自動增強方法不同,PointAugment具有樣本感知功能,并采用對抗學習策略來共同優化增強器網絡和分類網絡,學習生成最適合分類器的增強樣本。PointAugment根據形狀分類器和點位移來構造可學習的點增強函數,并根據分類器的學習進度精心設計損失函數以采用增強樣本。PointAugment在改善形狀分類和檢索中的有效性和魯棒性得到了實驗的驗證。

雷鋒網雷鋒網雷鋒網

相關文章:

今日 Paper | CVPR 2020 論文推薦:Social-STGCNN;無偏場景圖生成;深度人臉識別;4D 關聯圖等

雷峰網原創文章,未經授權禁止轉載。詳情見轉載須知。