0

| 本文作者: AI研習社 | 2020-02-19 15:34 |

用綜合方法預測2019-nCoV傳播的結束

通過被動WiFi傳感和數據挖掘了解社會事件中的人群行為

用于RGB-紅外行人重識別的交叉模態配對圖像生成

CTM:面向動作識別的協同時態建模

Music2Dance:使用WaveNet的音樂驅動的舞蹈生成

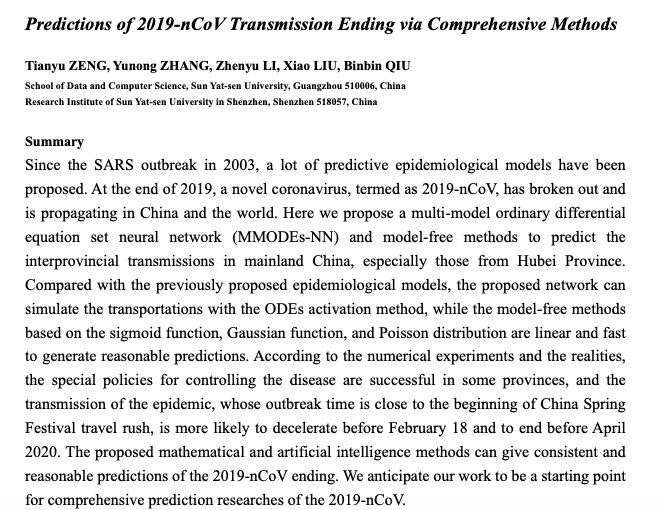

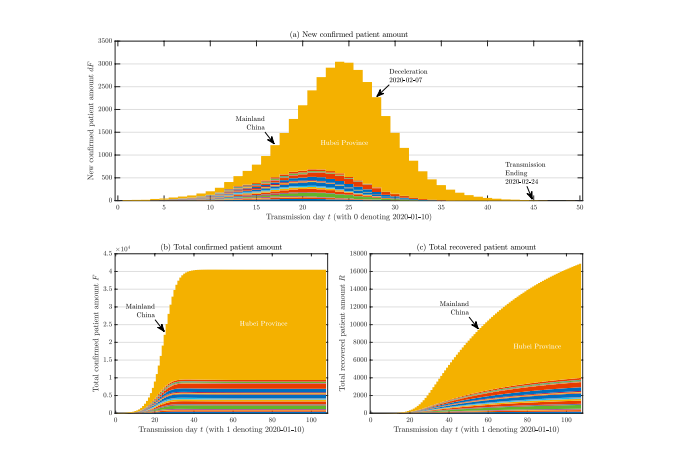

論文名稱:Predictions of 2019-nCoV Transmission Ending via Comprehensive Methods

作者:Zeng Tianyu /Zhang Yunong /Li Zhenyu /Liu Xiao /Qiu Binbin

發表時間:2020/2/12

論文鏈接:https://paper.yanxishe.com/review/11431?from=leiphonecolumn_paperreview0219

推薦原因

這篇論文試圖預測新型冠狀病毒的傳播,提出了一種多模態常微分方程神經網絡(Multi-Model Ordinary Differential Equation set Neural Network,MMODEs-NN)以及無模型方法,來預測疫情在中國大陸尤其是湖北省的擴散情況。與現有流行病學模型相比,這篇論文提出的方法可以使用常微分方程激活法來模擬傳播,而基于S形函數、高斯函數和Poisson分布的無模型方法是線性的,因而非常高效。根據數值實驗與實情,為了控制疫情擴散的特別政策在一些省取得效果,目前預測這股疫情可能在2月18日之前減速并在2020年4月之前結束。這篇論文所提的數學和人工智能方法可以對2019-nCoV的結束給出一致且合理的預測。

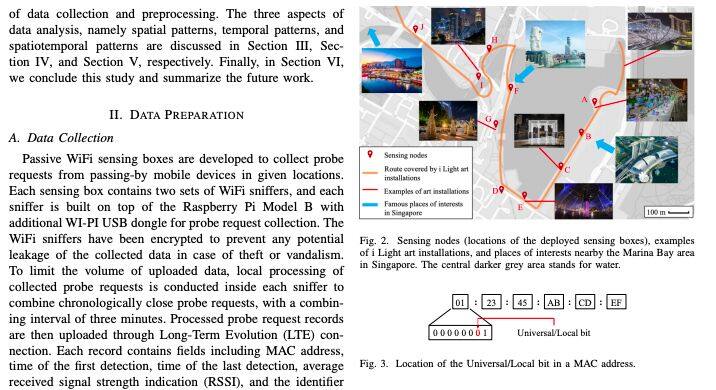

論文名稱:Understanding Crowd Behaviors in a Social Event by Passive WiFi Sensing and Data Mining

作者:Zhou Yuren /Lau Billy Pik Lik /Koh Zann /Yuen Chau /Ng Benny Kai Kiat

發表時間:2020/2/5

論文鏈接:https://paper.yanxishe.com/review/11308?from=leiphonecolumn_paperreview0219

推薦原因

這篇論文通過WiFi傳感數據進行人群行為分析。

通過收集從移動設備發送的WiFi請求,無源WiFi感測提供了一種比人群計數器和攝像機更好的監控人群的方法。在現有研究中,對收集數據的全面分析和挖掘沒有給予足夠重視。這篇論文提出一個全面的數據分析框架,以在統計、可視化和無監督機器學習幫助下,全面分析收集的探測請求,以提取與大型社交事件中的人群行為相關的三種類型模式。這個分析框架首先從探測請求中提取移動設備的軌跡并進行分析,以揭示人群運動的空間模式。然后采用分層聚集聚類法來查找不同位置之間的互連。接下來應用K均值和K聚類算法分別按天數和位置提取人群的時間訪問模式。最后通過與時間結合,軌跡被轉換為時空模式,揭示了軌跡持續時間如何隨長度變化,以及人群運動的總體趨勢如何隨時間變化。這個數據分析框架通過在大型社交事件中收集的真實數據進行了驗證。

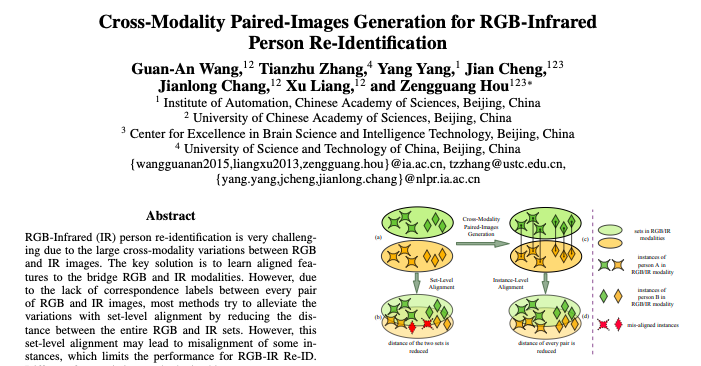

論文名稱:Cross-Modality Paired-Images Generation for RGB-Infrared Person Re-Identification

作者:Wang Guan-An /Yang Tianzhu Zhang. Yang /Cheng Jian /Chang Jianlong /Liang Xu /Hou Zengguang

發表時間:2020/2/10

論文鏈接:https://paper.yanxishe.com/review/11306?from=leiphonecolumn_paperreview0219

推薦原因

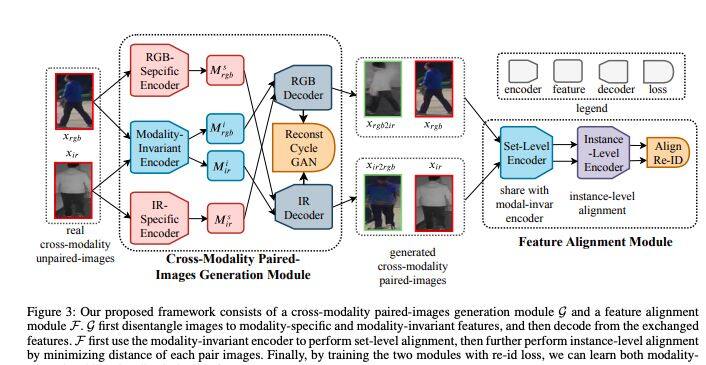

這篇論文要解決的是行人重識別問題。

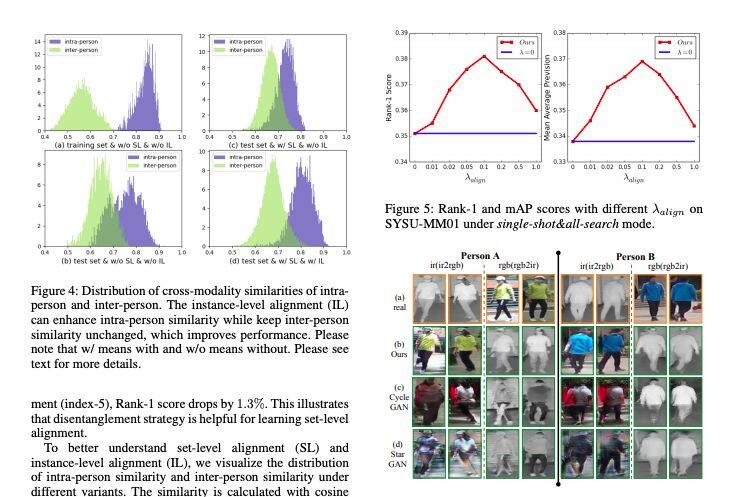

RGB和IR圖像之間缺少對應標簽,會導致某些實例的對齊錯誤,從而限制RGB-IR Re-ID的性能。與現有方法不同,這篇論文提出生成跨模態配對圖像,并執行全局集合級和細粒度實例級對齊。這種方法可以通過解開特定于模態和模態不變的特征來執行集合級對齊。與傳統方法相比,所提方法可以顯式刪除特定于模態的特征,并且可以更好地減少模態變化。給定一個人的跨模態不成對圖像,所提方法可以從交換的圖像生成跨模態成對圖像,通過最小化每對圖像的距離直接執行實例級對齊。在兩個標準基準上的大量實驗結果表明,所提模型有利于抗衡當前最佳方法,特別是在SYSU-MM01數據集上,所提模型在Rank-1和mAP方面可以實現9.2%和7.7%的提升。

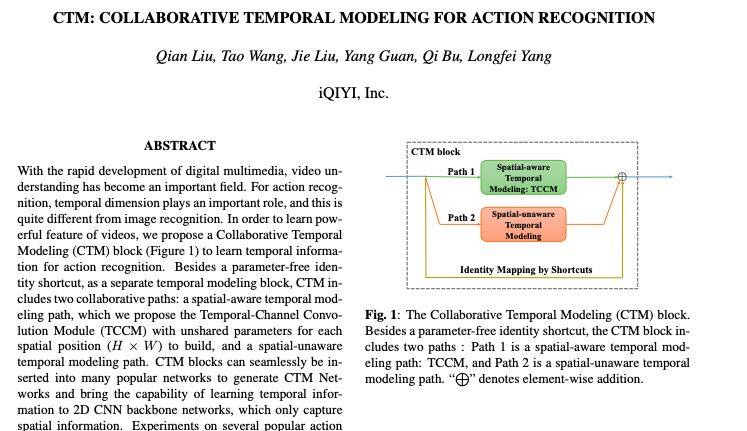

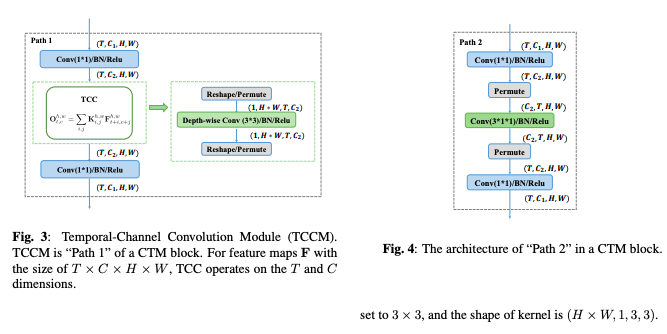

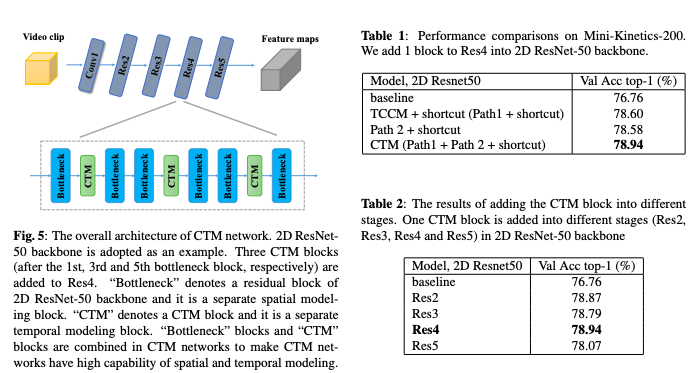

論文名稱:CTM: Collaborative Temporal Modeling for Action Recognition

作者:Liu Qian /Wang Tao /Liu Jie /Guan Yang /Bu Qi /Yang Longfei

發表時間:2020/2/8

論文鏈接:https://paper.yanxishe.com/review/11182?from=leiphonecolumn_paperreview0219

推薦原因

這篇論文要解決的是動作識別問題。

與圖像識別任務不同,動作識別任務對于時間維度的要求更高。為了學習到視頻的強大特征,這篇論文提出了一個名為CTM的協同時間模型來學習時間信息。CTM作為一個單獨的時間建模模塊,包括了兩條協作路徑:一個空間感知的時間建模路徑和一個無空間感知的時間建模路徑。CTM模型可以無縫地插入許多流行的神經網絡模型中以生成CTM網絡,可以將學習時間信息的能力帶給僅捕獲了空間信息的2D CNN骨干網絡中。在幾個流行的動作識別數據集上進行的實驗表明,CTM塊在2D CNN基線模型上帶來了性能提升。

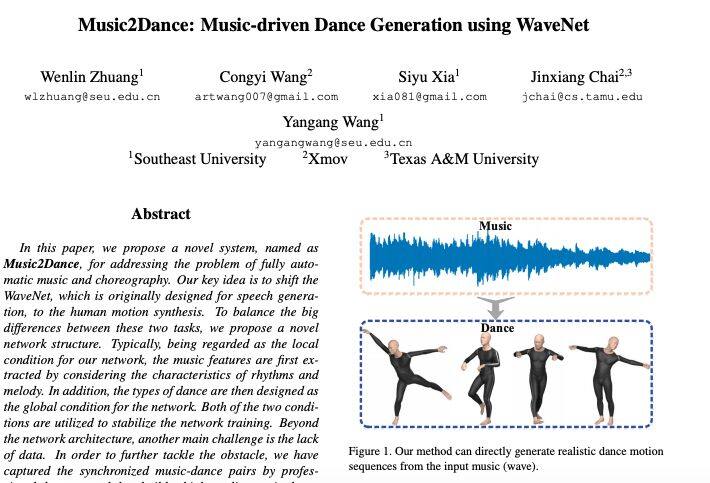

論文名稱:Music2Dance: Music-driven Dance Generation using WaveNet

作者:Zhuang Wenlin /Wang Congyi /Xia Siyu /Chai Jinxiang /Wang Yangang

發表時間:2020/2/2

論文鏈接:https://paper.yanxishe.com/review/11181?from=leiphonecolumn_paperreview0219

推薦原因

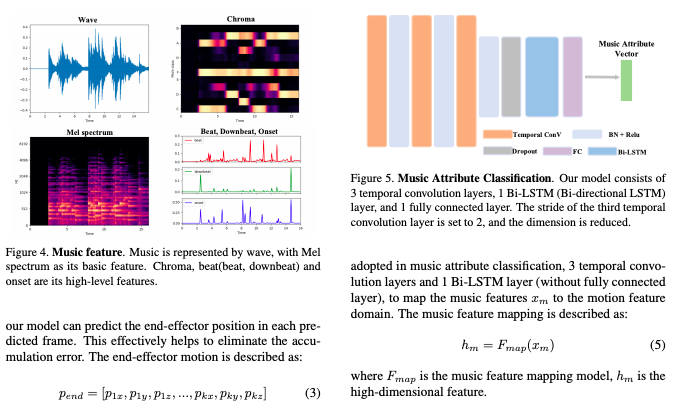

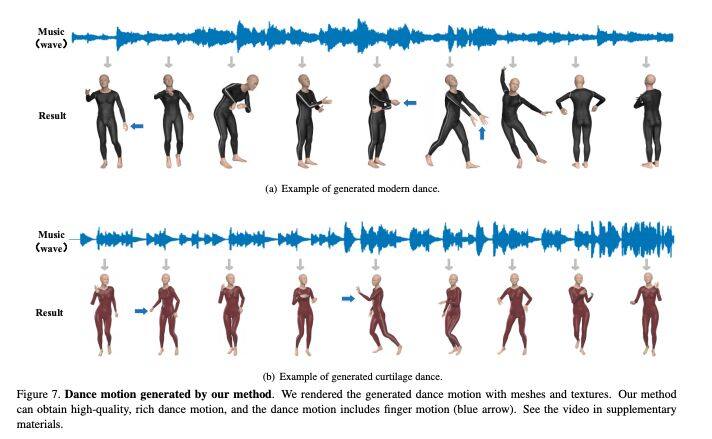

這篇論文提出了一個名為Music2Dance的模型,用于解決全自動音樂編排的問題。

Music2Dance的主要思想是將最初為語音生成而設計的WaveNet轉變為人體運動合成,首先通過考慮節奏和旋律的特征來提取音樂特征,接著將舞蹈的類型設計為網絡的全局條件。為了解決數據缺乏的挑戰,這篇論文收集捕捉了專業舞者同步的音樂舞蹈對,從而建立了高質量的音樂舞蹈對數據集。這個數據集上的實驗表明了Music2Dance的有效性。

為了更好地服務廣大 AI 青年,AI 研習社正式推出全新「論文」版塊,希望以論文作為聚合 AI 學生青年的「興趣點」,通過論文整理推薦、點評解讀、代碼復現。致力成為國內外前沿研究成果學習討論和發表的聚集地,也讓優秀科研得到更為廣泛的傳播和認可。

我們希望熱愛學術的你,可以加入我們的論文作者團隊。

加入論文作者團隊你可以獲得

1.署著你名字的文章,將你打造成最耀眼的學術明星

2.豐厚的稿酬

3.AI 名企內推、大會門票福利、獨家周邊紀念品等等等。

加入論文作者團隊你需要:

1.將你喜歡的論文推薦給廣大的研習社社友

2.撰寫論文解讀

如果你已經準備好加入 AI 研習社的論文兼職作者團隊,可以添加運營小姐姐的微信,備注“論文兼職作者”

雷鋒網雷鋒網雷鋒網

相關文章:

今日 Paper | 社交媒體謠言檢測;連續手語識別;細粒度服裝相似性學習;混合圖神經網絡等

今日 Paper | 旋轉不變混合圖形模型網絡;人體移動軌跡;行人再識別;基準成像系統等

今日 Paper | 從純圖像重建世界;層次遞歸網絡序列;注意力神經網絡;命名實體識別等

今日 Paper | 梯度剪切;命名實體識別;自然語言處理;免強度函數學習等

今日 Paper | 小樣本學習;機器學習;單幅圖像去霧 ;零樣本目標檢測等

今日 Paper | 可視問答模型;神經風格差異轉移;圖像壓縮系統 ;K-SVD圖像去噪等

今日 Paper | 依賴性解析器;DNNs對圖像損壞;高效人臉特征學習 ;虛擬試穿統一框架等

今日 Paper | 模態平衡模型;組合語義分析;高表達性SQL查詢;多人姿態估計模型等

今日 Paper | 多人姿勢估計;對話框語義分析;無監督語義分析;自然語言處理工具包等

今日 Paper | 多人線性模型;身體捕捉;會話問答;自然語言解析;神經語義

今日 Paper | 手部和物體重建;三維人體姿態估計;圖像到圖像變換等

今日 Paper | 動態手勢識別;領域獨立無監督學習;基于BERT的在線金融文本情感分析等

今日 Paper | 新聞推薦系統;多路編碼;知識增強型預訓練模型等

今日 Paper | 小樣本學習;視覺情感分類;神經架構搜索;自然圖像摳像等

今日 Paper | 蚊子叫聲數據集;提高語音識別準確率;對偶注意力推薦系統等

今日 Paper | 人臉數據隱私;神經符號推理;深度學習聊天機器人等

今日 Paper | 虛擬試穿網絡;人群計數基準;聯邦元學習;目標檢測等

今日 Paper | 人體圖像生成和衣服虛擬試穿;魯棒深度學習;圖像風格遷移等

今日 Paper | 隨機微分方程;流式自動語音識別;圖像分類等

今日 Paper | 高維感官空間機器人;主動人體姿態估計;深度視頻超分辨率;行人重識別等

雷峰網原創文章,未經授權禁止轉載。詳情見轉載須知。